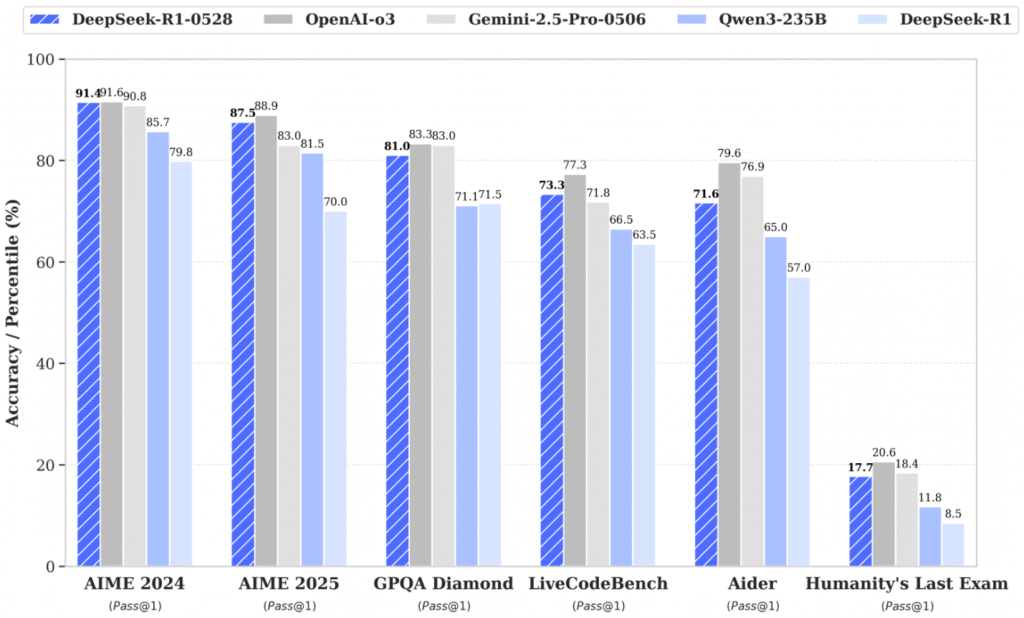

Команда DeepSeek представила оновлену версію моделі DeepSeek-R1-0528, яка демонструє суттєве підвищення якості у порівнянні з попередньою версією R1. Архітектура самої моделі залишилася незмінною, проте був значно вдосконалений процес навчання.

Основні особливості та результати

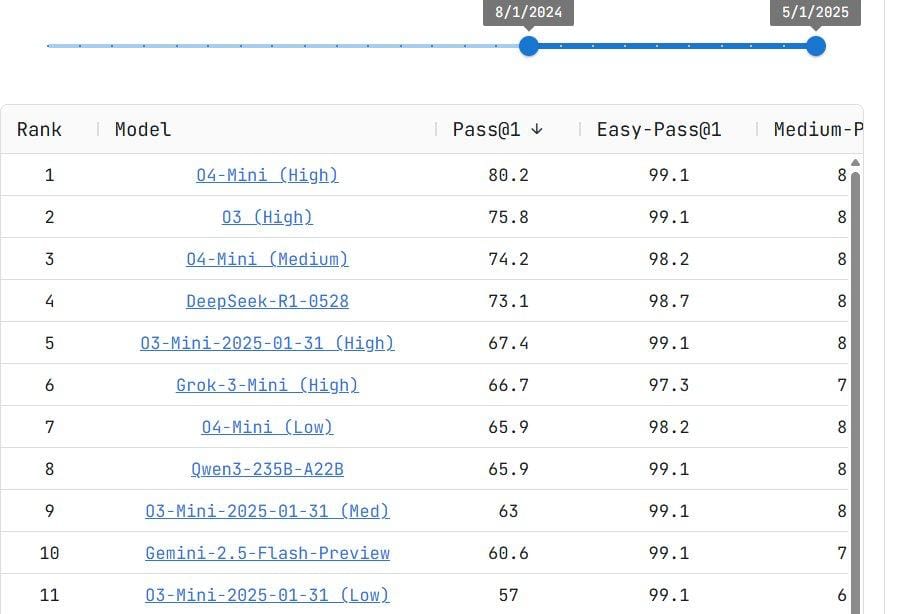

- Покращення у всіх аспектах: Модель показує кращі результати у тестах LiveBench та інших стандартних бенчмарках.

- Дистилят на базі Qwen3-8B: Окрім основної моделі R1-0528, доступна також полегшена версія DeepSeek-R1-0528-Qwen3-8B, створена на основі Qwen3-8B.

Локальний запуск моделі

DeepSeek-R1-0528 доступна для локального запуску у форматі GGUF.

- 78-бітна версія моделі потребує близько 185 ГБ пам’яті (плюс розмір контексту).

- Для запуску в останніх версіях llama.cpp та ik_llama можна використовувати параметри

-otабо--override-tensorдля точного керування розподілом тензорів між CPU та GPU. - Наприклад, команда:

-ot ".ffn_.*_exps.=CPU" -ngl 99дозволяє розмістити ваги окремих експертів (MoE) на CPU, а основні — на GPU, що забезпечує суттєве прискорення обчислень навіть при використанні однієї відеокарти. - Якщо пам’яті не вистачає, рекомендується додати параметр

--ubatch-size 1для запуску з SSD — це дозволить обробляти батчі по одному, що зменшує навантаження на диск.

Онлайн-демо та API

- Для ознайомлення із можливостями моделі доступний безкоштовний API та чат через OpenRouter.

- Нова версія вже доступна онлайн на офіційному сайті DeepSeek Chat.

➡️ Нuggingface тут.