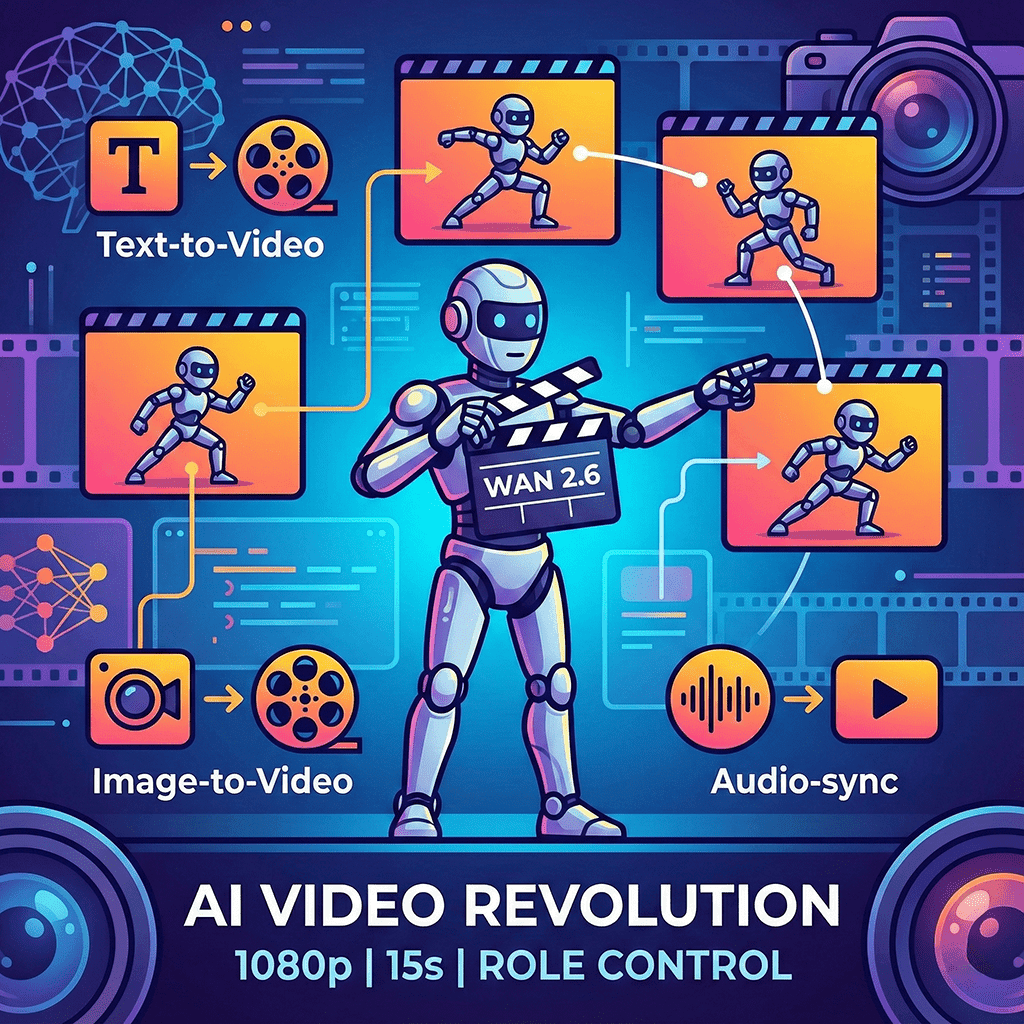

У Китаї офіційно представили Wan 2.6 — інноваційну модель для генерації відео, яка стала першою в країні відеомоделлю з підтримкою рольових функцій. Розробка робить акцент не просто на створенні кліпів, а на побудові повноцінних сцен із персонажами, звуком та логічною взаємодією між елементами.

Wan 2.6 поєднує відео та аудіо в єдиний наратив: модель уміє синхронізувати рухи, мову, ефекти та зміну кадрів. Завдяки підтримці кількох камер і багатокадрової структури, відео виглядає значно більш кінематографічно, ніж у більшості класичних text-to-video моделей.

🔹 Ключові можливості Wan 2.6

- Text-to-Video та Image-to-Video з роздільною здатністю до 1080p

- Тривалість відео до 15 секунд без втрати цілісності сцени

- Інтелектуальна сегментація сцен — автоматичний поділ на логічні кадри

- Підтримка рольових персонажів (starring roles) із чіткою ідентичністю

- Імпорт власного аудіо: голоси, музика, звукові ефекти

- Робота з 1–3 референсними відео для збереження консистентності персонажів, об’єктів і стилю

- Багатокамерна зйомка з плавними переходами між планами

🔹 Чим Wan 2.6 відрізняється від інших відеомоделей

На відміну від багатьох конкурентів, Wan 2.6 фокусується не лише на візуальній якості, а й на сюжетній логіці. Персонажі “пам’ятають” свою роль у сцені, рухаються послідовно, а звук не виглядає випадковим доповненням, а частиною сценарію.

Це робить модель особливо цікавою для:

- короткометражних AI-фільмів

- TikTok / Reels / Shorts-контенту

- рекламних роликів

- сторітелінгу з повторюваними героями

- експериментального кіно та гейм-катсцен

🔗 Де спробувати Wan 2.6

➡️ Офіційний сайт:

https://create.wan.video/generate/video/starring-roles?model=wan2.6

➡️ Fal:

https://fal.ai/models/wan/v2.6/reference-to-video

➡️ Replicate:

https://replicate.com/wan-video/wan-2.6-t2v