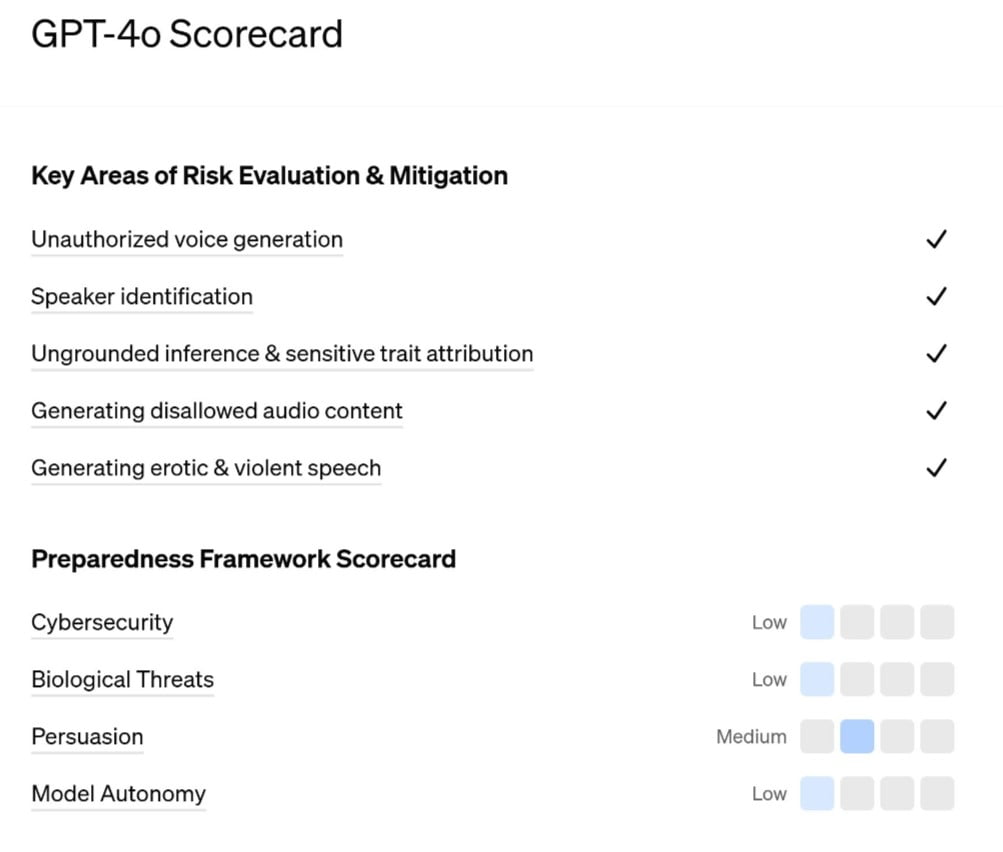

OpenAI поділилася системною картою для GPT-4o та випустила оціночну карту Preparedness Framework, щоб забезпечити наскрізну оцінку безпеки моделі. Також компанія розповіла про обмеження ШІ та оцінки безпеки за кількома категоріями.

OpenAI провела більше роботи із забезпечення безпеки, зосередившись на аудіоможливостях GPT-4o. Оцінювані ризики охоплюють ідентифікацію мовця, несанкціоновану генерацію голосу, потенційне створення контенту, захищеного авторським правом, необґрунтовані висновки та заборонений контент. Ґрунтуючись на результатах цих оцінок, OpenAI впровадила заходи безпеки як на рівні моделі, так і на рівні системи.

GPT-4o набрала низькі бали в трьох із чотирьох категорій Preparedness Framework, а також середній бал за переконливістю. OpenAI зазначає, що можна розгортати тільки моделі із середньою або нижчою оцінкою.

Компанія співпрацює з більш ніж 100 зовнішніми учасниками “червоних команд” для оцінки моделі перед її випуском. Вони оцінять нові потенційні ризики, створювані моделлю, і проведуть стрес-тестування заходів щодо пом’якшення наслідків.

Команда OpenAI пообіцяла “відстежувати й оновлювати заходи з пом’якшення наслідків відповідно до мінливої обставини”.

У травні OpenAI презентувала нову мовну модель GPT-4o. Вона може сприймати та генерувати звук, зображення і текст і доступна всім користувачам безкоштовно. З кінця липня аудіоможливості моделі стали доступними для передплатників ChatGPT Plus.

На початку серпня з OpenAI пішов ще один співзасновник і ключовий фахівець із безпеки ШІ Джон Шульман. Він оголосив, що приєднується до АІ-стартапу Anthropic, створеного колишніми дослідниками OpenAI.