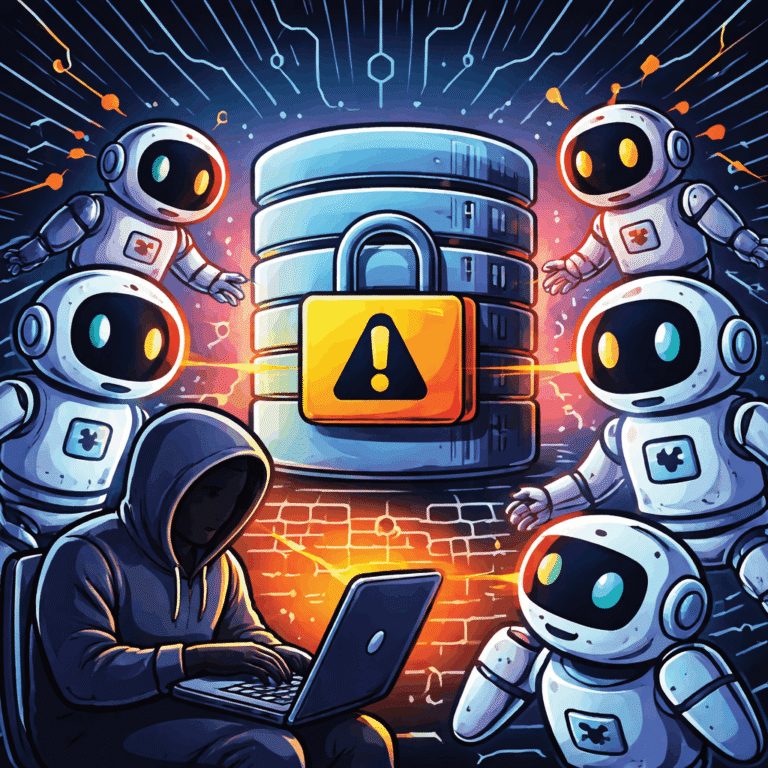

OpenAI прагне впроваджувати політику, яка запобігає зловживанням і підвищує прозорість контенту, створеного штучним інтелектом. Це особливо стосується виявлення та припинення операцій прихованого впливу (ОВ), які намагаються маніпулювати громадською думкою або впливати на політичні результати, не розкриваючи справжню особистість або наміри тих, хто за ними стоїть. Читайте повний звіт

За останні три місяці OpenAI припинили п’ять прихованих ОВ, які намагалися використати моделі чат gpt онлайн для підтримки оманливої діяльності в інтернеті. Станом на травень 2024 року ці кампанії, схоже, не змогли суттєво збільшити свою аудиторію або охоплення завдяки штучному інтелекту.

OpenAI розповіли про зловмисників, яким вони протидіяли, тенденції зловмисників, які вони виявили, та важливі тенденції захисту – зокрема про те, як розробка моделей штучного інтелекту з урахуванням безпеки в багатьох випадках завадила зловмисникам генерувати бажаний для них контент і як інструменти штучного інтелекту підвищили ефективність.

OpenAI зірвали операцію:

Операцію з Росії, про яку раніше не повідомлялося і яку OpenAI назвали «Погана граматика», що діяла переважно в Telegram і була націлена на Україну, Молдову, країни Балтії та Сполучені Штати. Люди, які стоять за «Поганою граматикою», використовували моделі штучного інтелекту для налагодження коду та запуску бота в Telegram і створення коротких політичних коментарів російською та англійською мовами, які потім публікувалися в Telegram.

Операція, що походить з Росії, відома під назвою «Двійник». Люди, які діяли від імені «Двійника», використовували моделі ШІ для створення коментарів англійською, французькою, німецькою, італійською та польською мовами, які були розміщені на X і 9GAG; перекладу та редагування статей англійською та французькою мовами, які були розміщені на сайтах, пов’язаних з цією операцією; створення заголовків; і перетворення новинних статей на пости в Facebook.

Контент, розміщений цими різними операціями, зосереджувався на широкому спектрі питань, включаючи вторгнення Росії в Україну, конфлікт у Газі, вибори в Індії, політику в Європі та США, а також критику китайського уряду з боку китайських дисидентів та іноземних урядів.

OpenAI прагне розробляти безпечний і відповідальний ШІ, що передбачає розробку моделей з урахуванням безпеки та проактивне втручання проти зловмисного використання. Виявлення та припинення багатоплатформних зловживань, таких як операції прихованого впливу, може бути складним завданням, оскільки OpenAI не завжди знає, як поширюється контент, створений штучним інтелектом. Але прагне виявляти та зменшувати масштаби таких зловживань, використовуючи можливості генеративного ші.